Il file robots.txt serve per poter comunicare con i motori di ricerca. Infatti, oltre Google, tutti i motori di ricerca utilizzano dei crawler, ovvero dei software che analizzano i contenuti della rete e vanno alla ricerca in modo automatico delle pagine da indicizzare.

Robots.txt è un file di testo che devi creare per dire a robot particolari come i crawler dei motori di ricerca a quali aree del tuo sito possono accedere e da quali aree dovrebbero stare alla larga.

Il file Robots.txt in questo caso in WordPress può essere utilizzato per impedire agli spider di eseguire la scansione di determinate pagine del tuo sito, ad esempio se non sono importanti o non contengono contenuti di valore. Puoi anche usarlo per dire loro di non eseguire la scansione della stessa pagina due volte per evitare problemi di contenuto duplicato.

Il file robots.txt di WordPress, svolge quindi un ruolo decisivo nel posizionamento di un sito web deve essere compilato correttamente. Prima di capire come gestire al meglio questo file per evitare problemi, bisogna capire bene che cos’è il file robots.txt, quando e come utilizzarlo.

Non sei esperto in WordPress e stai cercando qualcuno che possa risolvere il problema al posto tuo? Contatta la nostra assistenza WordPress per risolvere qualsiasi problema in poche ore.

Cos’è il file robots.txt

Il file robots.txt è un semplice file di testo, che viene scritto con il classico programma di Windows, Blocco Note, e che va posizionato nella cartella root (radice) del proprio sito web, assicurandosi che abbia la giusta estensione “.txt”. Per cercare e visualizzare questo file basta scrivere l’url del proprio sito seguito dal nome del file.

Ad esempio: www.miositoweb.it/robots.txt

Il file robots.txt viene utilizzato per comunicare con i motori di ricerca. All’interno del file, infatti, vengono scritte delle indicazioni che i crawler andranno a leggere. In base alle indicazioni fornite attraverso semplici stringhe di testo, i software dei motori di ricerca capiranno se indicizzare quel contenuto o meno.

La possibilità di indicare ai search engine cosa indicizzare e cosa invece lasciare fuori dalla loro scansione permette anche di evitare che il server su cui viene ospitato il sito web venga sovraccaricato. Un sito lento verrebbe penalizzato nell’indicizzazione sui motori di ricerca.

Infatti, e’ possibile anche evitare che alcune pagine ritenute non rilevanti vengano scansionate dai crawler. Se invece si vuole escludere completamente una pagina del sito dall’indicizzazione dei motori di ricerca, rendendola praticamente invisibile, è meglio utilizzare il tag “nofollow” inserendolo nella sezione head della pagina web, in alternativa, impostando questa indicazione nei plugin di WordPress.

Ecco un esempio del tag “noindex” in un file html:

<meta name=”robots” content=”noindex”>

Come compilare correttamente il file robots txt WordPress

La prima parola che andremo ad inserire nel nostro file di testo sarà la dicitura “user-agent”. Questo termine si riferisce, e va a richiamare, il robot utilizzato dal motore di ricerca che va ad analizzare il nostro sito web.

Ogni motore di ricerca ha uno specifico user-agent e, oltre al nome dello specifico crawler, si può anche far in modo che il sito sia considerato da tutti i motori di ricerca o solo da alcuni.

Ecco qualche esempio:

Nel primo esempio (user-agent: *) si indica che il sito può essere indicizzato da tutti i motori di ricerca; nel secondo, la regola (user-agent: Googlebot) specifica che il file sarà letto solo dal crawler di Google e, nell’ultimo esempio, ci si rivolge solo al robot di Bing (user-agent: bingbot).

Online è possibile consultare la lista dei crawler dei principali motori di ricerca.

La seconda voce che troviamo nel file robots.txt, ovvero “Disallow” indica invece ai crawlers di non scansionare alcune pagine o files presenti nel sito in modo tale da non sovraccaricare eccessivamente il server. Ovviamente, questa indicazione ha più senso se si ha a che fare con siti web di grandi dimensioni.

Ad esempio, basterà scrivere

User-agent: *

Disallow: /foto/

Per indicare al motore di ricerca di non considerare la directory /foto o, ancora, scrivendo

User-agent: *

Disallow: /foto/*jpg

I motori di ricerca sapranno che potranno considerare i files presenti nella cartella foto, ma non quelli con estensione .jpg.

In realtà, sono diverse le sintassi per “Disallow” che possono essere utilizzate e si possono indicare a proprio piacimento in base alle diverse esigenze.

Come posizionare correttamente il file robots.txt in WordPress

Il file robots.txt va inserito nella directory principale del sito WordPress. Come abbiamo accennato prima, infatti, sarà accessibile visitando la seguente url: www.miositoweb.it/robots.txt .

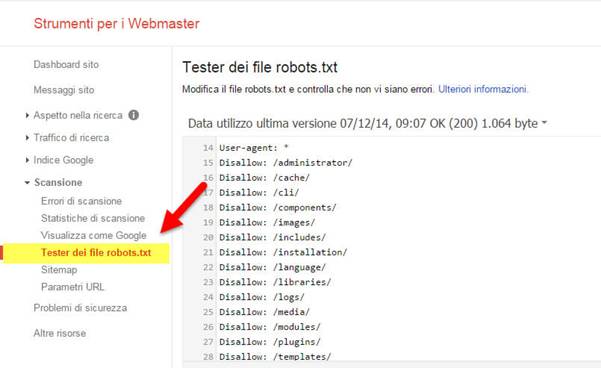

Bisogna fare molta attenzione a dare il giusto nome al file e controllare che l’estensione sia quella giusta. Ad esempio, stai attento a non rinominarlo in “robotstxt” oppure “robots txt”, il file dovrà essere rinominato in robots.txt. Per verificare che il file robots.txt sia scritto e posizionato correttamente, sono utili anche gli strumenti per webmaster messi a disposizione da Google, come la Google Search Console.

Una volta inserito il sito per cui si vuole avviare la verifica del file robots.txt, basta selezionare la voce “Scansione > Tester dei file robots.txt“ dal menu a sinistra.

Come utilizzare il file robots.txt su WordPress

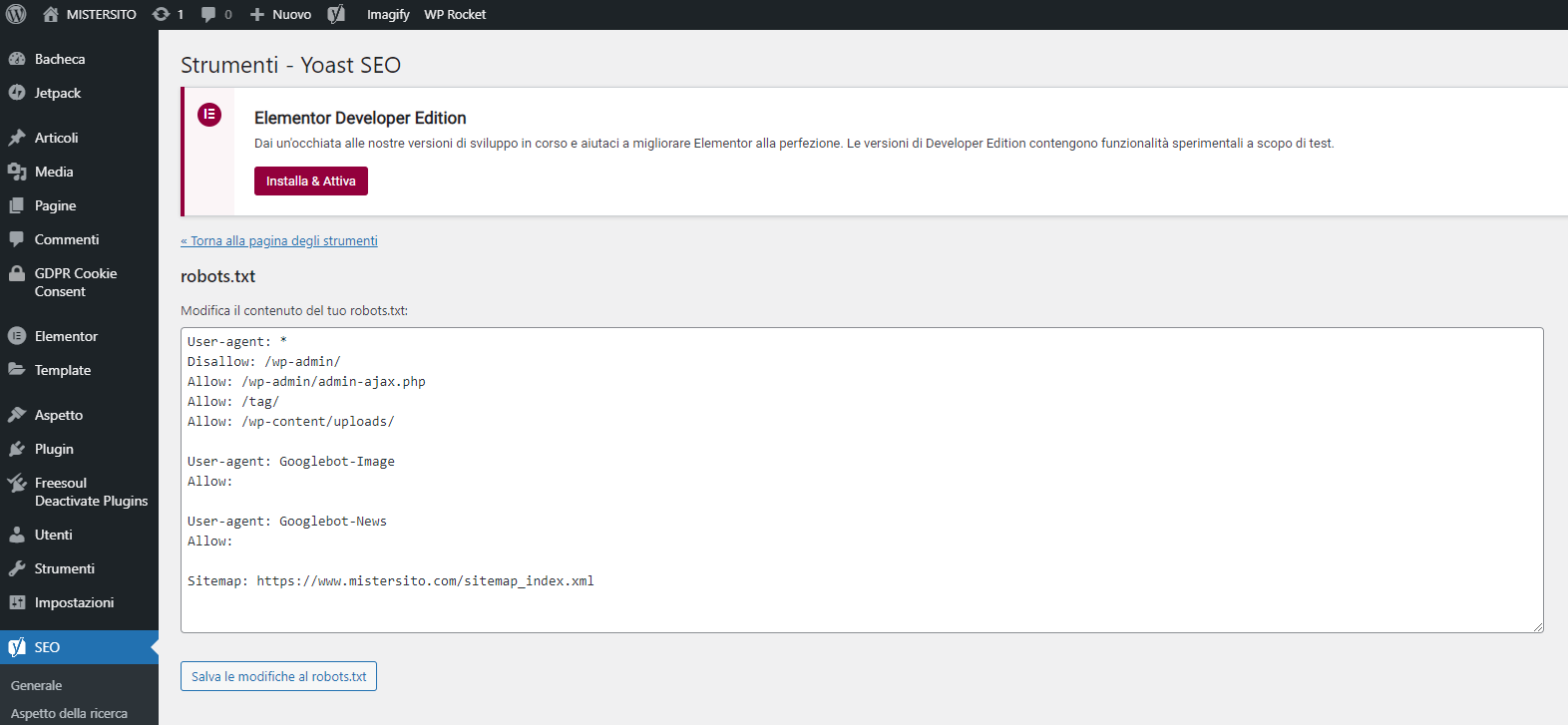

Le indicazioni che ti abbiamo fornito finora sono valide in generale per qualunque sito, ma se utilizzi WordPress puoi contare anche su una serie di plugin che ti permettono di gestire ed editare il file robots.txt direttamente dal backend di WordPress. Poiché molti di questi add-ons forniscono già delle regole di base, si tratta di una scelta adatta per chi è alle prime armi.

In realtà, siccome si tratta di una procedura molto semplice, conviene operare direttamente sul file di testo.